Un database di big data è ottimo per comprendere i tuoi problemi attuali o futuri. L'esecuzione di un'analisi rapida utilizzando l'approccio giusto può aiutarti a decidere quale database ti aiuterà di più. Tuttavia, se le tue esigenze non vengono soddisfatte, potresti dover capire quali strumenti soddisfano meglio le tue esigenze. Di seguito abbiamo raccolto i nostri 17 principali database di big data open source da provare e siamo sicuri che li amerai tanto quanto noi.

Che cos'è un "database di Big Data"?

Un "Big Data Database" è un sistema di gestione di database online che consente di archiviare e analizzare enormi quantità di dati. I big data si riferiscono alla quantità di informazioni memorizzate in un database, generalmente misurate in petabyte (1 Petabyte = 1.000 Terabyte). Un petabyte è un milione di gigabyte o 1 milione di volte più grande di un terabyte. Ciò significa che il tuo database tipico avrà milioni di diversi tipi di dati archiviati in un dato momento (forse anche più di un petabyte).

Definizione di database di Big Data

I database di big data archiviano enormi quantità di dati, inclusi dati strutturati, semi-strutturati e non strutturati, con schemi fissi minimi o assenti. Questi database NoSQL altamente scalabili possono raccogliere dati da varie fonti, come social media, dispositivi Internet of Things (IoT) e applicazioni.

Stati di Wikipedia la definizione di Big Data Database COME:

"I big data sono il luogo in cui sono necessari strumenti di calcolo parallelo per gestire i dati", e osserva, "Questo rappresenta un cambiamento distinto e chiaramente definito nell'informatica utilizzata, attraverso teorie di programmazione parallela, e perdite di alcune delle garanzie e delle capacità apportate da Codd's modello relazionale”.

— Paragrafi tratti da Wikipedia

Le caratteristiche principali dei database di dati estesi includono:

- Enorme capacità di archiviazione (petabyte) e capacità di scalare facilmente.

- Nessuno schema fisso o schema minimo per massimizzare la flessibilità. Gli schemi di dati si evolvono man mano che i dati vengono archiviati.

- Ottimizzato per l'analisi delle relazioni e l'acquisizione di informazioni da set di dati di grandi dimensioni.

- Spesso basato su soluzioni di database NoSQL open source come Cassandra, MongoDB, Hadoop/HDFS, ecc.

- Consenti l'archiviazione e il recupero rapidi e affidabili di Big Data su vasta scala per casi d'uso come:

- AdTech e Martech: Memorizza i dati sulle prestazioni di annunci e campagne

- Sicurezza informatica: registri, avvisi e dati macchina per l'analisi

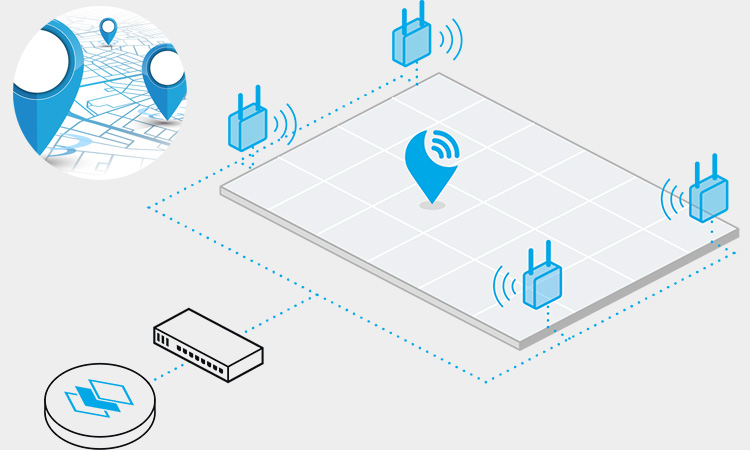

- IoT: aggrega i dati da dispositivi, sensori, sistemi e apparecchiature connessi

- Social media: post, commenti, Mi piace, condivisioni e altri dati sui social network

- Consegna/Trasporto: tiene traccia di percorsi, ETA, consumo di carburante, logistica e altro ancora

- Media/Intrattenimento: vaste librerie di contenuti, visualizzazioni, commenti, raccomandazioni

- Vendita al dettaglio/e-commerce: transazioni, cataloghi, prezzi, inventario, clienti su larga scala

Cosa fanno i database di Big Data?

Big data I database NoSQL archiviano enormi volumi di dati per supportare analisi e approfondimenti impegnativi su vasta scala. Sono spesso utilizzati in settori e casi d'uso come:

Vendita al dettaglio

- Catalogo dei prodotti: Dati di prodotto veloci e reattivi per mantenere i clienti coinvolti con uno schema adattabile.

- Cliente 360: Arricchisci i profili dei clienti con dati contestuali, comportamentali e basati sugli eventi.

- Carrello della spesa: Riduci l'abbandono con carrelli persistenti su tutti i canali/dispositivi, monitorando i modelli di acquisto per una migliore customer intelligence.

- Motore di raccomandazione: Sfrutta i dati contestuali e comportamentali per alimentare il machine learning, aumentando le vendite con consigli pertinenti.

- Programma fedeltà e promozioni: Migliora il coinvolgimento e la fidelizzazione con dati in tempo reale e sconti/incentivi mirati.

- L'evasione degli ordini: Tieni traccia degli ordini end-to-end, riducendo al minimo le perdite e aumentando la soddisfazione.

- Gestione delle scorte: Mantieni inventari ottimali e riduci al minimo gli avvisi di esaurimento scorte con la gestione distribuita dell'inventario.

Social media

- Profilo utente: Memorizza attributi, preferenze, tag, interessi e cronologie per centinaia di milioni di utenti interconnessi con prestazioni coerenti e affidabili.

- Conversazioni: Utilizza operazioni di database a bassa latenza per fornire un'esperienza superiore con comunicazioni in tempo reale, connessioni più veloci e ritardo minimo.

- Tracciamento della posizione: Crea app e giochi social reattivi basati sulla posizione sfruttando i flussi di posizione dai dispositivi degli utenti.

- Risorse multimediali: Archiviazione ad alte prestazioni per oggetti binari di grandi dimensioni come immagini, video e file audio.

AdTech e MarTech

- Targeting degli annunci di precisione: Pubblica annunci ad alto volume in base a impressioni, entrate e obiettivi della campagna determinando i contenuti più coinvolgenti per individui e pubblico.

- Analisi in tempo reale: Ottieni informazioni utili da vasti dati in tempo reale per guidare decisioni dinamiche.

- Apprendimento automatico: Esegui rapidamente carichi di lavoro operativi e di analisi sugli stessi set di dati e infrastruttura.

- Comportamento e impressioni degli utenti: Cattura e analizza i flussi di clic in tempo reale per comprendere il sentiment, individuare le tendenze e ottimizzare le campagne.

Database relazionali (RDBMS) vs database non relazionali (non RDBMS)

ecco una tabella che riassume alcune delle principali differenze tra database relazionali (RDBMS) e database non relazionali (non RDBMS):

| Caratteristica | RDBMS | Non RDBMS |

|---|---|---|

| Modello di dati | Tabelle con schema rigoroso | Vari modelli di dati, inclusi documento, valore-chiave, grafico e famiglia di colonne |

| Scalabilità | Ridimensionamento verticale con limiti | Ridimensionamento orizzontale con facilità |

| Interrogazione | Query basate su SQL | Query non basate su SQL |

| Conformità ACIDO | Transazioni completamente compatibili con ACID | Eventuale coerenza o parziale conformità ACID |

| Integrità dei dati | Forte integrità e coerenza dei dati | Integrità flessibile dei dati ed eventuale coerenza |

| Flessibilità dei dati | Limitato ai dati strutturati | Supporta dati semi-strutturati e non strutturati |

| Modifiche allo schema | Le modifiche allo schema richiedono tempi di inattività | Lo schema dinamico cambia senza tempi di inattività |

| Archivio dati | Ottimizzato per l'efficienza di archiviazione | Ottimizzato per le prestazioni delle query |

| Casi d'uso | Ideale per i sistemi transazionali | Ideale per requisiti di dati flessibili, a bassa latenza e ad alto volume |

| Esempi | Oracle, MySQL, SQL Server | MongoDB, Cassandra, HBase |

Perché creare database di Big Data?

Il motivo principale per la creazione di database di big data è assicurarsi di poter accedere ai propri dati quando necessario. Supponiamo che tu non mantenga aggiornato il tuo database di big data con le ultime modifiche al tuo sito web o alla tua attività. In tal caso, non sarai in grado di visualizzare informazioni importanti quando necessario, ad esempio quando i clienti acquistano prodotti o effettuano pagamenti.

I sistemi di Big Data Database possono aiutare le aziende a risparmiare denaro riducendo i costi dei server. Tuttavia, offrono altri vantaggi come maggiori misure di sicurezza e un migliore servizio clienti, tutto perché c'è più spazio per tutto!

TOP 12 database di Big Data Open Source

Apache Cassandra

Apache Cassandra è un database orientato alle colonne che può essere scalato fino a centinaia di migliaia di nodi. Include un sistema di replica dei dati integrato, che consente di mantenere la coerenza tra più istanze di database. Supporta la specifica Advanced Data Types (ADT) e offre molte altre funzionalità, come l'alta disponibilità e la tolleranza ai guasti. Puoi usarlo in molte applicazioni, tra cui analisi in tempo reale, data warehousing e applicazioni di business intelligence.

Alcune delle migliori caratteristiche di Cassandra includono:

- Progettazione flessibile dello schema: puoi creare schemi ottimizzati per le tue esigenze di dati e applicazioni

- Letture e scritture veloci: le scritture sono in genere più veloci delle letture perché utilizza una tecnica di archiviazione di righe strutturata in log, che riduce la quantità di I/O su disco necessaria per elaborare gli aggiornamenti.

- Alta disponibilità: Cassandra può essere distribuita su più macchine con funzionalità ad alta disponibilità come sharding e replica

Apache HBase

Apache HBase è un database di big data open-source che memorizza grandi quantità di dati non strutturati. Può gestire dati strutturati e non strutturati ed è adatto per l'archiviazione di registri e altri dati di serie temporali.

Apache HBase viene eseguito su un file system distribuito, che gli consente di scalare fino a enormi quantità di dati mantenendo una bassa latenza.

HBase ha anche il supporto integrato per la memorizzazione nella cache, la replica e lo sharding. HBase è una scelta eccellente se hai bisogno di un accesso rapido ai tuoi dati mantenendoli al sicuro.

MongoDB

Se stai cercando un database in grado di gestire il volume di dati della tua azienda, allora MongoDB è una delle migliori opzioni. MongoDB è una piattaforma software di database open source orientata ai documenti. È basato sul motore di database NoSQL non relazionale Mongoose ed è progettato per gestire elevati volumi di dati di molti tipi.

MongoDB ha un robusto framework di raccolta in grado di archiviare documenti di tutte le forme e dimensioni, inclusi documenti JSON, oggetti nidificati e array. Supporta lavori MapReduce e offre funzionalità come funzioni geospaziali, aggregazione e indici.

MongoDB esiste dal 2004 ed è diventato uno dei database più popolari. Dozzine di grandi aziende come eBay, PayPal e Twitter lo supportano.

Neo4j

Neo4j è un database grafico che sviluppatori e data scientist possono utilizzare per archiviare relazioni complesse tra oggetti in un database, consentendo l'elaborazione rapida di grandi quantità di dati. È basato sul progetto JavaSpaces open source, originariamente sviluppato da IBM. Neo4j è sviluppato da Neo Technology e Apache Software Foundation, che mantengono anche la sua base di codice open source.

Il progetto è iniziato nel 1999 come concorrente di altri database grafici come Redhawk di Oracle o Microsoft Graph, ma è diventato un prodotto leader del settore. L'API Neo4j consente agli sviluppatori di creare applicazioni ottimizzate per l'analisi su larga scala e l'apprendimento automatico e persino di eseguirle su dispositivi mobili!

L'API Neo4j è stata adottata da molte aziende e organizzazioni in tutto il mondo, tra cui Facebook, Yahoo!, LinkedIn, eBay e grandi aziende come Philips e Vodafone. Ci sono oltre 60 milioni di utenti registrati di Neo4j oggi!

HDFS (file system distribuito Hadoop)

HDFS è un file system distribuito che gestisce file di grandi dimensioni su hardware di base. È il file system predefinito per Hadoop, il che lo rende un'ottima scelta per l'archiviazione dei dati. Il principale vantaggio dell'utilizzo di HDFS è che può scalare fino a più cluster su scala petabyte, rendendolo una scelta eccellente se si dispone di un set di dati di grandi dimensioni da archiviare e analizzare.

Spark MLlib (libreria di apprendimento automatico Spark)

Spark MLlib è una libreria di machine learning open source per Apache Spark che fornisce una raccolta di algoritmi di machine learning. È progettato per essere facile da usare, scalabile e affidabile. Ha molti utenti, il che lo rende una delle migliori soluzioni di database di big data che puoi iniziare a utilizzare oggi.

Spark MLlib dispone di un'ampia gamma di algoritmi che puoi utilizzare durante l'esecuzione di attività di machine learning come la classificazione e la regressione. La libreria supporta vari modelli, come modelli lineari, modelli non lineari (kernelizzati), insiemi di alberi, foreste casuali, reti neurali profonde e altro ancora. Nella libreria sono disponibili anche molti modelli pre-addestrati, come la regressione logistica, la regressione lineare e le macchine vettoriali di supporto.

La libreria di machine learning Spark include anche una varietà di strumenti. Ti aiuta a eseguire attività comuni fornendo modelli predefiniti o frammenti di codice che puoi utilizzare come elementi costitutivi del modello, ad esempio la selezione delle funzionalità o l'addestramento di un modello.

Apache CouchDB

Apache CouchDB è un database basato su documenti che consente di archiviare dati strutturati e non strutturati. È scritto in JavaScript, non ha schemi e può essere utilizzato come database NoSQL. Ciò consente di utilizzarlo come soluzione di archiviazione dati scalabile per la tua app. È basato sul progetto open source CouchDB, creato da sviluppatori esperti di aziende come Facebook e Yahoo. La società dietro CouchDB è DataStax, che produce anche database Cassandra e Voldemort, tra gli altri.

CouchDB è disponibile in diverse lingue, tra cui PHP5/PHP7+ e NodeJS + web pack + Gulp + npm (richiede NodeJS). Non ha dipendenze esterne oltre a NPM e Webpack.

OrientDB

OrientDB è una delle migliori soluzioni di database Big Data in circolazione. Non solo ha un'interfaccia straordinaria, ma include anche un ricco set di funzionalità e strumenti per l'analisi e la visualizzazione dei dati. OrientDB è anche facile da ridimensionare in base alle esigenze.

Con OrientDB, puoi fare cose davvero sorprendenti con i tuoi dati, tra cui:

- Scopri nuove informazioni nei tuoi dati utilizzando tag cloud o visualizzazioni interattive.

- Aggiungi metadati ai tuoi dati in modo da potervi accedere facilmente in seguito.

- Utilizza le query SQL per trovare rapidamente informazioni specifiche sul tuo set di dati (ad esempio, in che mese è avvenuta questa transazione?)

FlockDB

FlockDB è un nuovo database di big data open source che utilizza Apache Hadoop per archiviare ed elaborare i dati. FlockDB memorizza i dati in tabelle e indici nei file Apache Parquet. Consente agli utenti di eseguire query utilizzando la sintassi SQL e fornisce strumenti per l'ottimizzazione, l'indicizzazione e l'elaborazione delle query.

Il motore di archiviazione dei dati di FlockDB è progettato per essere veloce ed efficiente. Supporta cluster a nodo singolo e multinodo con un massimo di 10 nodi per cluster. Gli utenti possono anche configurare FlockDB per l'elevata disponibilità configurando la replica su più nodi nel cluster o raggruppando le istanze di FlockDB su macchine fisiche o virtuali separate.

Il database supporta i lavori MapReduce, consentendo agli utenti di eseguire calcoli su larga scala sui propri dati utilizzando linguaggi di programmazione MapReduce come Java, Python o Scala.

Riac

Riak è un database chiave/valore distribuito che fornisce alta disponibilità, scalabilità ed estensibilità. È stato originariamente sviluppato da una società chiamata Talis Holdings, acquisita da HP nel 2011. La società è ora nota come HPE Labs e da allora è stata incorporata nella sua organizzazione. Le caratteristiche principali di Riak sono:

- Alta disponibilità: se un nodo si guasta, può essere sostituito da un altro nodo nel cluster

- Scalabilità: può scalare orizzontalmente per gestire grandi quantità di dati

- Estensibilità: supporta plug-in che possono aggiungere nuove funzionalità

Territorio

Terstore è un database di big data basato su Apache Cassandra. È un database NoSQL, il che significa che utilizza JSON per il suo modello di dati. Terstore offre una gamma di funzionalità per l'archiviazione e l'interrogazione di set di dati di grandi dimensioni, incluso il supporto per la geometria dei poligoni, i dati geografici e persino l'analisi del testo.

È scritto in Java. La parte migliore di Terstore è che è facile da configurare e utilizzare fin da subito. Non sono richiesti passaggi di installazione; basta scaricare i file, decomprimerli e iniziare a utilizzare il database! Restore viene fornito con utili tutorial che ti guidano attraverso l'impostazione del tuo primo progetto e la documentazione di riferimento su come utilizzare al meglio Terstore all'interno delle tue applicazioni.

Terrstore è open source, quindi se vuoi creare qualcosa di nuovo con questo database o estenderlo, sentiti libero! Tuttavia, ricorda che alcune funzionalità potrebbero non essere ancora disponibili (come l'indicizzazione spaziale).

Cassandra

Cassandra è un sistema di gestione di database distribuiti open source (DBMS). È un archivio dati valore-chiave altamente scalabile, ad alte prestazioni, tollerante agli errori e altamente disponibile. È stato progettato per gestire grandi quantità di dati su più nodi senza compromettere la disponibilità, la coerenza o la durabilità.

Supporta più tipi di dati come stringhe, hash, insiemi e insiemi ordinati come tipi di base combinati utilizzando chiavi per creare oggetti indipendenti che formano una tabella. Cassandra supporta anche il partizionamento dello spazio vettoriale per un'elevata disponibilità e scalabilità.

Le caratteristiche notevoli di Cassandra includono:

- Alta disponibilità

- Alte prestazioni

- Alto rendimento

- Scalabilità

- Consistenza

Miglior confronto tra database di Big Data

AWS Dynamo DB

AWS DynamoDB è il miglior database da utilizzare per le startup. È un servizio di database NoSQL su richiesta, duraturo e scalabile che puoi utilizzare in molte applicazioni.

È progettato per operazioni di lettura/scrittura ad alte prestazioni con bassa latenza e throughput prevedibile. Offre prestazioni costanti e disponibilità elevata con scalabilità automatica e ripristino di emergenza immediatamente disponibile.

DynamoDB fornisce anche un singolo indice partizionato a basso overhead in tutte le tabelle del cluster. Supporta vincoli di chiave primaria ed esterna e funzionalità di ricerca full-text per il recupero rapido dei dati da set di dati di grandi dimensioni.

Il vantaggio principale dell'utilizzo di DynamoDB rispetto ad altri database è la sua capacità di scalare rapidamente quando sono necessarie risorse di elaborazione aggiuntive senza dover pagare costi aggiuntivi o attendere lunghi periodi prima che siano nuovamente disponibili.

Azure Cosmo DB

Azure Cosmos DB è un database NoSQL creato appositamente per le esigenze delle applicazioni Big Data. È progettato per gestire enormi quantità di dati e offre flessibilità nell'utilizzo.

Cosmos DB usa un'architettura di archivio di valori-chiave e consente di archiviare qualsiasi tipo di oggetto al suo interno. Non si limita solo alla memorizzazione dei dati relativi alla tua azienda; puoi usarlo per i file di registro o qualsiasi altra cosa che deve essere archiviata.

Cosmos DB è basato su un motore di archiviazione a colonne, che consente di archiviare grandi quantità di dati in modo efficiente senza richiedere spazio aggiuntivo sul disco rigido o sulla RAM. Ciò significa che Cosmos DB occuperà meno spazio rispetto ad altri tipi di database rispetto ad altre opzioni disponibili in Azure.

Una grande caratteristica di Cosmos DB è la sua capacità di scalare su più server; se un server si guasta, un altro può assumerne la funzione senza influire sulle prestazioni dell'applicazione o del database.

Amazon Keyspace

Amazon Keyspaces è un database NoSQL che archivia e gestisce facilmente i dati nel cloud. È progettato per grandi quantità di dati, con più colonne per riga e nessuno schema, il che lo rende ideale per l'archiviazione di grandi set di informazioni non strutturate. Il software open source è disponibile su piattaforme Java, Python, C++ e Node.js.

Caratteristiche principali:

- Design senza schema per una facile scalabilità

- Memorizza fino a 2 PB di dati per istanza

- Supporta l'autenticazione tramite le credenziali AWS

Amazon DocumentDB

Amazon DocumentDB è uno dei migliori database di big data per il confronto. Ha un motore di query che può essere eseguito in parallelo e analizzare rapidamente i dati, rendendolo ideale per grandi quantità di dati. Anche il suo supporto per query complesse è impressionante, semplificando la ricerca delle informazioni pertinenti di cui hai bisogno.

Il database Amazon DocumentDB è un componente aggiuntivo di Amazon RDS o Amazon EC2. Supporta fino a 1 miliardo di documenti e 10 miliardi di record per nodo del cluster. È inoltre supportato da un accordo sul livello di servizio (SLA) leader del settore.

Il client Data Studio è uno strumento visivo che ti aiuta a gestire i tuoi dati con strumenti come dashboard e grafici. Puoi utilizzarlo per AWS Cloud Search per trovare documenti, analizzarli utilizzando modelli di machine learning ed eseguire ricerche per parole chiave o frasi. Il servizio Data Pipeline consente di estrarre dati strutturati da qualsiasi fonte in un formato strutturato come JSON o XML prima di inviarli ad altri sistemi, come Redshift o Elasticsearch, per scopi di analisi.

Spostamento rosso Amazon

Amazon Redshift è un data warehouse veloce, affidabile e conveniente per il cloud. È basato sul progetto open source Apache Phoenix ed è disponibile in diverse dimensioni, da 32 GB a 250 TB. Ha un'interfaccia SQL completa e supporta database relazionali e non relazionali.

Amazon Redshift offre molte funzionalità che lo rendono particolarmente adatto per il data warehousing:

- Interfaccia SQL completa

- Supporta database relazionali e non relazionali

- Memorizza in modo sicuro i tuoi dati in un formato crittografato sull'infrastruttura automatizzata di AWS.

Oltre a queste caratteristiche, Amazon Redshift offre altri grandi vantaggi:

- È facile da configurare e utilizzare, il che significa che puoi iniziare a usarlo subito senza bisogno di una conoscenza approfondita della gestione dell'infrastruttura IT o di competenze di programmazione avanzate.

- Paghi solo per ciò che utilizzi, senza costi anticipati o impegni a lungo termine con questo servizio.

- Amazon Redshift aiuta le aziende a gestire le crescenti richieste di big data, che si tratti di archiviare dati strutturati o non strutturati.

Se sei un'azienda e hai bisogno di raccogliere enormi quantità di dati per supportare i tuoi sforzi di marketing, dovresti prendere in considerazione l'utilizzo di un database di big data open source. Questi strumenti possono analizzare tutti i dati che stai raccogliendo e darti accesso a statistiche utili. Renderanno il tuo lavoro molto più semplice e ti aiuteranno a mettere in atto informazioni più accurate.

Informazioni sul problema del database di Big Data

-

Che cos'è un database Big Data e in che modo è diverso dai database tradizionali?

Un database Big Data è un database progettato per gestire e gestire grandi volumi di dati strutturati, semi-strutturati e non strutturati. Ciò differisce dai database tradizionali, in genere progettati per gestire solo dati strutturati.

-

In che modo i database Big Data gestiscono l'archiviazione e l'elaborazione di grandi volumi di dati?

I database Big Data utilizzano in genere architetture di calcolo e archiviazione distribuite, come Hadoop e Apache Spark, per gestire grandi volumi di archiviazione ed elaborazione dei dati. Queste architetture consentono di archiviare ed elaborare i dati su più nodi in un cluster, migliorando le prestazioni e la scalabilità.

-

Quali sono alcuni dei database Big Data più popolari e quali sono le loro caratteristiche principali?

Alcuni famosi database di Big Data includono Apache HBase, MongoDB, Cassandra e Couchbase. Questi database sono progettati per gestire grandi volumi di dati, fornire scalabilità e prestazioni e supportare l'elaborazione e l'analisi dei dati in tempo reale.

-

In che modo i database Big Data supportano l'elaborazione e l'analisi dei dati in tempo reale?

I database Big Data supportano l'elaborazione e l'analisi dei dati in tempo reale fornendo funzionalità come l'elaborazione in memoria, il calcolo distribuito e i motori di analisi in tempo reale. Queste funzionalità consentono l'elaborazione e l'analisi dei dati in tempo reale, consentendo alle aziende di prendere decisioni più rapide e informate.

-

Quali sono i vantaggi dell'utilizzo di un database Big Data per la business intelligence e l'analisi?

I vantaggi dell'utilizzo di un database Big Data per la business intelligence e l'analisi includono migliori prestazioni di elaborazione e analisi dei dati, scalabilità e capacità di gestire grandi volumi di dati. Ciò consente alle aziende di ricavare insight dai propri dati in modo più rapido ed efficace, portando a un migliore processo decisionale e a un vantaggio competitivo.

-

In che modo i database Big Data supportano l'apprendimento automatico e le applicazioni di intelligenza artificiale?

I database di Big Data supportano le applicazioni di machine learning e intelligenza artificiale fornendo funzionalità come analisi in tempo reale, preelaborazione dei dati e integrazione con framework di machine learning. Ciò consente alle aziende di creare e distribuire modelli di machine learning utilizzando grandi volumi di dati.

-

In che modo i database Big Data gestiscono dati non strutturati, come testo, immagini e video?

I database Big Data gestiscono dati non strutturati utilizzando tecniche di indicizzazione dei documenti, analisi del testo e riconoscimento delle immagini. Queste tecniche consentono di elaborare e analizzare i dati non strutturati in un formato strutturato, consentendo alle aziende di ricavare approfondimenti da questi dati.

-

In che modo i database Big Data gestiscono la coerenza e l'affidabilità dei dati?

I database Big Data gestiscono la coerenza e l'affidabilità dei dati attraverso funzionalità come la replica e la tolleranza agli errori. Queste funzionalità assicurano che i dati vengano archiviati ed elaborati in modo affidabile, anche durante guasti hardware o altri problemi.

-

In che modo i database Big Data gestiscono i backup dei dati e il ripristino di emergenza?

I database di Big Data gestiscono i backup dei dati e il ripristino di emergenza tramite funzionalità quali replica dei dati, procedure di backup e ripristino e piani di ripristino di emergenza. Queste funzionalità assicurano che i dati possano essere recuperati durante un'emergenza o una perdita.

-

Quali sono le considerazioni sulle prestazioni quando si lavora con i database Big Data?

Quando si lavora con database Big Data, le considerazioni sulle prestazioni includono volume di dati, modelli di accesso ai dati e configurazione hardware. Le aziende potrebbero aver bisogno di utilizzare tecniche per ottimizzare le prestazioni, come il partizionamento dei dati, l'indicizzazione e la memorizzazione nella cache.

-

In che modo i database Big Data gestiscono la governance e la conformità dei dati?

I database di Big Data gestiscono la governance e la conformità dei dati attraverso funzionalità come il controllo degli accessi, l'auditing e la reportistica sulla conformità. Queste funzionalità garantiscono che i dati vengano gestiti in conformità con i requisiti normativi e di conformità.

-

Quali sono le considerazioni sui costi durante l'implementazione e la gestione di un database Big Data?

Le considerazioni sui costi durante l'implementazione e la gestione di un database Big Data includono hardware, licenze e costi di manutenzione e supporto continui. Le aziende potrebbero dover considerare fattori per ridurre al minimo i costi, come la compressione dei dati, l'ottimizzazione dell'hardware e le opzioni software open source.