Eine große Datendatenbank ist großartig, um Ihre aktuellen oder zukünftigen Probleme zu verstehen. Eine schnelle Analyse mit dem richtigen Ansatz kann Ihnen bei der Entscheidung helfen, welche Datenbank Ihnen am meisten hilft. Wenn Ihre Anforderungen jedoch nicht erfüllt werden, müssen Sie möglicherweise herausfinden, welche Tools Ihre Anforderungen am besten erfüllen. Nachfolgend haben wir unsere 17 besten Open-Source-Big-Data-Datenbanken für Sie zum Ausprobieren zusammengestellt – und wir sind sicher, dass Sie sie genauso lieben werden wie wir.

Was ist eine „Big Data Datenbank“?

Eine „Big Data Database“ ist ein Online-Datenbankverwaltungssystem, mit dem Sie riesige Datenmengen speichern und analysieren können. Big Data bezieht sich auf die Menge an Informationen, die in einer Datenbank gespeichert sind, typischerweise gemessen in Petabyte (1 Petabyte = 1.000 Terabyte).. Ein Petabyte ist eine Million Gigabyte oder 1 Million Mal größer als ein Terabyte. Dies bedeutet, dass Ihre typische Datenbank zu jedem Zeitpunkt Millionen verschiedener Arten von Daten gespeichert hat (möglicherweise sogar mehr als ein Petabyte).

Big-Data-Datenbankdefinition

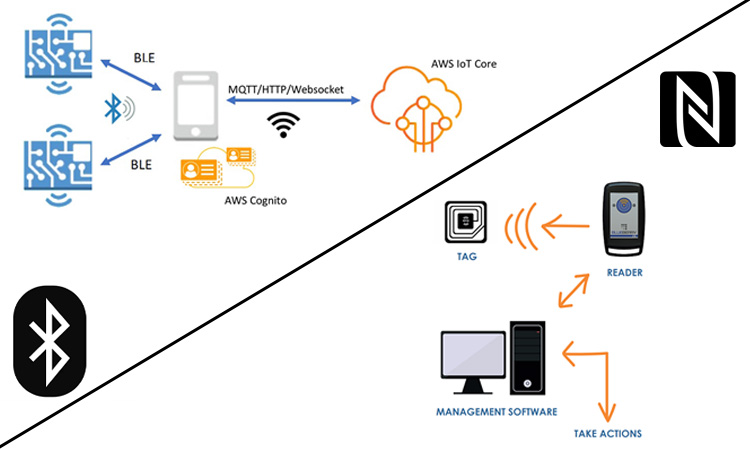

Big-Data-Datenbanken speichern enorme Datenmengen, einschließlich strukturierter, halbstrukturierter und unstrukturierter Daten, mit minimalen oder keinen festen Schemas. Diese massiv skalierbaren NoSQL-Datenbanken können Daten aus verschiedenen Quellen wie sozialen Medien, Internet of Things (IoT)-Geräten und Anwendungen sammeln.

Wikipedia sagt die Definition von Big Data Database als:

„Bei Big Data werden parallele Rechenwerkzeuge benötigt, um Daten zu verarbeiten“, und stellt fest: „Dies stellt eine deutliche und klar definierte Änderung in der verwendeten Informatik dar, über parallele Programmiertheorien und den Verlust einiger der von Codd's gegebenen Garantien und Fähigkeiten relationales Modell.“

— Absätze aus Wikipedia übernommen

Zu den Hauptmerkmalen umfangreicher Datendatenbanken gehören:

- Riesige Speicherkapazität (Petabyte) und einfache Skalierbarkeit.

- Kein festes Schema oder minimales Schema, um die Flexibilität zu maximieren. Datenschemata entwickeln sich, wenn Daten gespeichert werden.

- Optimiert für die Analyse von Beziehungen und Gewinnung von Erkenntnissen aus großen Datensätzen.

- Häufig basierend auf Open-Source-NoSQL-Datenbanklösungen wie Cassandra, MongoDB, Hadoop/HDFS usw.

- Ermöglichen Sie schnelles, zuverlässiges Speichern und Abrufen von Big Data in großem Maßstab für Anwendungsfälle wie:

- AdTech und Martech: Speichert Anzeigen- und Kampagnenleistungsdaten

- Cybersicherheit: Protokolle, Warnungen und Maschinendaten zur Analyse

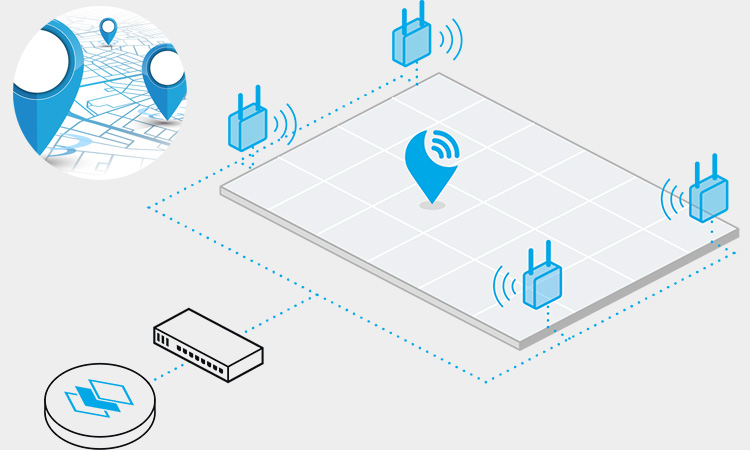

- IoT: Aggregiert Daten von verbundenen Geräten, Sensoren, Systemen und Anlagen

- Soziale Medien: Beiträge, Kommentare, Vorlieben, Freigaben und andere Daten sozialer Netzwerke

- Lieferung/Transport: Verfolgt Routen, ETA, Kraftstoffverbrauch, Logistik und mehr

- Medien/Unterhaltung: Riesige Bibliotheken mit Inhalten, Ansichten, Kommentaren, Empfehlungen

- Einzelhandel/E-Commerce: Transaktionen, Kataloge, Preise, Inventar, Kunden in großem Umfang

Was leisten Big-Data-Datenbanken?

Big Data NoSQL-Datenbanken speichern riesige Datenmengen, um anspruchsvolle Analysen und Erkenntnisse in großem Umfang zu unterstützen. Sie werden häufig in Branchen und Anwendungsfällen eingesetzt wie:

Einzelhandel

- Produktkatalog: Schnelle, reaktionsschnelle Produktdaten, um Kunden mit einem anpassbaren Schema zu beschäftigen.

- Kunde 360: Reichern Sie Kundenprofile mit kontext-, verhaltens- und ereignisgesteuerten Daten an.

- Einkaufswagen: Reduzieren Sie Abbrüche mit dauerhaften Warenkörben über Kanäle/Geräte hinweg und verfolgen Sie Kaufmuster für eine bessere Kundenintelligenz.

- Empfehlungsmaschine: Nutzen Sie Kontext- und Verhaltensdaten, um maschinelles Lernen zu füttern und den Umsatz mit relevanten Empfehlungen zu steigern.

- Treueprogramm und Aktionen: Verbessern Sie Engagement und Bindung mit Echtzeitdaten und gezielten Rabatten/Anreizen.

- Auftragsabwicklung: Verfolgen Sie Bestellungen durchgängig, minimieren Sie Verluste und steigern Sie die Zufriedenheit.

- Bestandsverwaltung: Pflegen Sie optimale Bestände und minimieren Sie Out-of-Stock-Meldungen mit verteiltem Bestandsmanagement.

Sozialen Medien

- Benutzerprofil: Speichern Sie Attribute, Präferenzen, Tags, Interessen und Historien für Hunderte Millionen miteinander verbundener Benutzer mit konsistenter, zuverlässiger Leistung.

- Gespräche: Nutzen Sie Datenbankoperationen mit geringer Latenz, um ein hervorragendes Erlebnis mit Echtzeitkommunikation, schnelleren Verbindungen und minimaler Verzögerung zu bieten.

- Standortverfolgung: Erstellen Sie reaktionsschnelle standortbasierte soziale Apps und Spiele, die Standort-Streams von Benutzergeräten nutzen.

- Media-Assets: Hochleistungsspeicher für große binäre Objekte wie Bilder, Videos und Audiodateien.

AdTech und MarTech

- Präzises Anzeigen-Targeting: Schalten Sie großvolumige Anzeigen basierend auf Impressionen, Einnahmen und Kampagnenzielen, indem Sie die ansprechendsten Inhalte für Einzelpersonen und Zielgruppen ermitteln.

- Echtzeitanalyse: Gewinnen Sie umsetzbare Erkenntnisse aus umfangreichen Echtzeitdaten, um dynamische Entscheidungen zu treffen.

- Maschinelles Lernen: Führen Sie Betriebs- und Analyse-Workloads schnell auf denselben Datensätzen und derselben Infrastruktur aus.

- Nutzerverhalten und Eindrücke: Erfassen und analysieren Sie Clickstreams in Echtzeit, um die Stimmung zu verstehen, Trends zu erkennen und Kampagnen zu optimieren.

Relationale Datenbanken (RDBMS) vs. nicht-relationale Datenbanken (Nicht-RDBMS)

Hier ist eine Tabelle, die einige der wichtigsten Unterschiede zwischen relationalen Datenbanken (RDBMS) und nicht-relationalen Datenbanken (Nicht-RDBMS) zusammenfasst:

| Besonderheit | RDBMS | Nicht-RDBMS |

|---|---|---|

| Datenmodell | Tabellen mit strengem Schema | Verschiedene Datenmodelle, einschließlich Dokument, Schlüsselwert, Diagramm und Spaltenfamilie |

| Skalierbarkeit | Vertikale Skalierung mit Grenzen | Einfaches horizontales Skalieren |

| Abfragen | SQL-basierte Abfragen | Nicht-SQL-basierte Abfragen |

| ACID-Konformität | Vollständig ACID-konforme Transaktionen | Endgültige Konsistenz oder teilweise ACID-Konformität |

| Datenintegrität | Starke Datenintegrität und -konsistenz | Flexible Datenintegrität und letztendliche Konsistenz |

| Datenflexibilität | Beschränkt auf strukturierte Daten | Unterstützt halbstrukturierte und unstrukturierte Daten |

| Schemaänderungen | Schemaänderungen erfordern Ausfallzeiten | Dynamische Schemaänderungen ohne Ausfallzeiten |

| Datenspeicherung | Optimiert für Speichereffizienz | Optimiert für die Abfrageleistung |

| Anwendungsfälle | Am besten geeignet für Transaktionssysteme | Am besten geeignet für hohe Datenvolumen, geringe Latenz und flexible Datenanforderungen |

| Beispiele | Oracle, MySQL, SQL-Server | MongoDB, Kassandra, HBase |

Warum Big-Data-Datenbanken erstellen?

Der Hauptgrund für die Erstellung von Big-Data-Datenbanken besteht darin, sicherzustellen, dass Sie bei Bedarf auf Ihre Daten zugreifen können. Angenommen, Sie halten Ihre Big-Data-Datenbank nicht mit den neuesten Änderungen an Ihrer Website oder Ihrem Unternehmen auf dem Laufenden. In diesem Fall können Sie bei Bedarf wichtige Informationen nicht sehen, z. B. wenn Kunden Produkte kaufen oder Zahlungen leisten.

Big-Data-Datenbanksysteme können Unternehmen dabei helfen, Geld zu sparen, indem sie die Serverkosten senken. Dennoch bieten sie weitere Vorteile wie erhöhte Sicherheitsmaßnahmen und besseren Kundenservice – alles nur, weil mehr Platz für alles vorhanden ist!

TOP 12 Open-Source-Big-Data-Datenbanken

Apache Kassandra

Apache Cassandra ist eine spaltenorientierte Datenbank, die auf Hunderttausende von Knoten skaliert werden kann. Es enthält ein integriertes Datenreplikationssystem, das Ihnen hilft, die Konsistenz über mehrere Datenbankinstanzen hinweg aufrechtzuerhalten. Es unterstützt die Advanced Data Types (ADT)-Spezifikation und bietet viele weitere Funktionen, wie z. B. Hochverfügbarkeit und Fehlertoleranz. Sie können es in vielen Anwendungen verwenden, einschließlich Echtzeitanalysen, Data Warehousing und Business-Intelligence-Anwendungen.

Zu den besten Funktionen von Cassandra gehören:

- Flexibles Schemadesign: Sie können Schemas erstellen, die für Ihre Daten- und Anwendungsanforderungen optimiert sind

- Schnelles Lesen und Schreiben: Schreibvorgänge sind in der Regel schneller als Lesevorgänge, da eine protokollstrukturierte Zeilenspeichertechnik verwendet wird, die die Menge an Festplatten-E/A reduziert, die zum Verarbeiten von Aktualisierungen erforderlich ist.

- Hohe Verfügbarkeit: Cassandra kann auf mehreren Computern mit Hochverfügbarkeitsfunktionen wie Sharding und Replikation bereitgestellt werden

Apache HBase

Apache HBase ist eine Open-Source-Big-Data-Datenbank, die große Mengen unstrukturierter Daten speichert. Es kann strukturierte und unstrukturierte Daten verarbeiten und eignet sich gut zum Speichern von Protokollen und anderen Zeitreihendaten.

Apache HBase wird auf einem verteilten Dateisystem ausgeführt, das eine Skalierung auf riesige Datenmengen bei geringer Latenz ermöglicht.

HBase bietet auch integrierte Unterstützung für Caching, Replikation und Sharding. HBase ist eine ausgezeichnete Wahl, wenn Sie schnellen Zugriff auf Ihre Daten benötigen und diese gleichzeitig sicher aufbewahren möchten.

MongoDB

Wenn Sie nach einer Datenbank suchen, die das Datenvolumen Ihres Unternehmens bewältigen kann, ist MongoDB eine der besten Optionen. MongoDB ist eine dokumentenorientierte Open-Source-Datenbanksoftwareplattform. Es basiert auf der nicht-relationalen NoSQL-Datenbank-Engine Mongoose und wurde entwickelt, um große Datenmengen über viele Typen hinweg zu verarbeiten.

MongoDB verfügt über ein robustes Sammlungsframework, das Dokumente aller Formen und Größen speichern kann, einschließlich JSON-Dokumente, verschachtelte Objekte und Arrays. Es unterstützt MapReduce-Jobs und bietet Funktionen wie Geofunktionen, Aggregation und Indizes.

MongoDB gibt es seit 2004 und hat sich zu einer der beliebtesten Datenbanken entwickelt. Dutzende von großen Unternehmen wie eBay, PayPal und Twitter unterstützen es.

Neo4j

Neo4j ist eine Graphdatenbank, mit der Entwickler und Data Scientists komplexe Beziehungen zwischen Objekten in einer Datenbank speichern können, was die schnelle Verarbeitung großer Datenmengen ermöglicht. Es basiert auf dem Open-Source-JavaSpaces-Projekt, das ursprünglich von IBM entwickelt wurde. Neo4j wird von Neo Technology und der Apache Software Foundation entwickelt, die auch ihre Open-Source-Codebasis pflegen.

Das Projekt begann 1999 als Konkurrenz zu anderen Graphdatenbanken wie Oracles Redhawk oder Microsoft Graph, wurde aber zu einem branchenführenden Produkt. Die Neo4j-API ermöglicht es Entwicklern, optimierte Anwendungen für umfangreiche Analysen und maschinelles Lernen zu erstellen – und sie sogar auf Mobilgeräten auszuführen!

Die Neo4j-API wurde von vielen Unternehmen und Organisationen weltweit übernommen, darunter Facebook, Yahoo!, LinkedIn, eBay und große Unternehmen wie Philips und Vodafone. Heute gibt es über 60 Millionen registrierte Benutzer von Neo4j!

HDFS (Hadoop Distributed File System)

HDFS ist ein verteiltes Dateisystem, das große Dateien auf handelsüblicher Hardware verarbeitet. Es ist das Standarddateisystem für Hadoop, was es zu einer großartigen Wahl zum Speichern Ihrer Daten macht. Der Hauptvorteil der Verwendung von HDFS besteht darin, dass es auf mehrere Petabyte-Cluster skaliert werden kann, was es zu einer ausgezeichneten Wahl macht, wenn Sie einen großen Datensatz speichern und analysieren müssen.

Spark MLlib (Spark-Bibliothek für maschinelles Lernen)

Spark MLlib ist eine Open-Source-Bibliothek für maschinelles Lernen für Apache Spark, die eine Sammlung von Algorithmen für maschinelles Lernen bereitstellt. Es ist so konzipiert, dass es einfach zu bedienen, skalierbar und zuverlässig ist. Es hat viele Benutzer, was es zu einer der besten Big-Data-Datenbanklösungen macht, die Sie heute verwenden können.

Spark MLlib verfügt über eine breite Palette von Algorithmen, die Sie verwenden können, wenn Sie maschinelle Lernaufgaben wie Klassifizierung und Regression ausführen. Die Bibliothek unterstützt verschiedene Modelle, wie z. B. lineare Modelle, nichtlineare Modelle (kernelisiert), Baumensembles, zufällige Gesamtstrukturen, tiefe neuronale Netze und mehr. In der Bibliothek sind auch viele vortrainierte Modelle verfügbar, wie z. B. logistische Regression, lineare Regression und Support-Vektor-Maschinen.

Die Spark-Bibliothek für maschinelles Lernen enthält auch eine Vielzahl von Tools. Es hilft Ihnen bei der Durchführung allgemeiner Aufgaben, indem es vorgefertigte Vorlagen oder Codeausschnitte bereitstellt, die Sie als Modellbausteine verwenden können, z. B. Featureauswahl oder Training eines Modells.

Apache CouchDB

Apache CouchDB ist eine dokumentbasierte Datenbank, mit der Sie strukturierte und unstrukturierte Daten speichern können. Es ist in JavaScript geschrieben, hat kein Schema und kann als NoSQL-Datenbank verwendet werden. Dadurch kann es als skalierbare Datenspeicherlösung für Ihre App verwendet werden. Es basiert auf dem Open-Source-CouchDB-Projekt, das erfahrene Entwickler von Unternehmen wie Facebook und Yahoo erstellt haben. Das Unternehmen hinter CouchDB ist DataStax, das unter anderem auch Cassandra- und Voldemort-Datenbanken herstellt.

CouchDB ist in mehreren Sprachen verfügbar, darunter PHP5/PHP7+ und NodeJS + Webpaket + Gulp + npm (es erfordert NodeJS). Es hat keine externen Abhängigkeiten außer NPM und Webpack.

OrientDB

OrientDB ist eine der besten Big-Data-Datenbanklösungen auf dem Markt. Es verfügt nicht nur über eine erstaunliche Benutzeroberfläche, sondern auch über eine Vielzahl von Funktionen und Tools zum Analysieren und Visualisieren von Daten. OrientDB lässt sich bei Bedarf auch einfach nach oben und unten skalieren.

Mit OrientDB können Sie einige ziemlich erstaunliche Dinge mit Ihren Daten machen, darunter:

- Entdecken Sie neue Einblicke in Ihre Daten, indem Sie Tag-Clouds oder interaktive Visualisierungen verwenden.

- Fügen Sie Ihren Daten Metadaten hinzu, damit Sie später einfach darauf zugreifen können.

- Verwenden Sie SQL-Abfragen, um schnell bestimmte Informationen zu Ihrem Datensatz zu finden (z. B. in welchem Monat fand diese Transaktion statt?).

FlockDB

FlockDB ist eine neue Open-Source-Big-Data-Datenbank, die Apache Hadoop zum Speichern und Verarbeiten von Daten verwendet. FlockDB speichert Daten in Tabellen und Indizes in Apache Parquet-Dateien. Es ermöglicht Benutzern, Abfragen mit SQL-Syntax zu erstellen, und stellt Tools für die Abfrageoptimierung, Indizierung und Verarbeitung bereit.

Die Datenspeicher-Engine von FlockDB ist auf Schnelligkeit und Effizienz ausgelegt. Es unterstützt Single-Node- und Multi-Node-Cluster mit bis zu 10 Nodes pro Cluster. Benutzer können FlockDB auch für Hochverfügbarkeit konfigurieren, indem sie die Replikation über mehrere Knoten im Cluster konfigurieren oder FlockDB-Instanzen auf separaten physischen oder virtuellen Maschinen gruppieren.

Die Datenbank unterstützt MapReduce-Jobs, sodass Benutzer mithilfe von MapReduce-Programmiersprachen wie Java, Python oder Scala umfangreiche Berechnungen mit ihren Daten durchführen können.

Riak

Riak ist eine verteilte Schlüssel/Wert-Datenbank, die Hochverfügbarkeit, Skalierbarkeit und Erweiterbarkeit bietet. Es wurde ursprünglich von einem Unternehmen namens Talis Holdings entwickelt, das HP 2011 übernommen hat. Das Unternehmen ist jetzt als HPE Labs bekannt und wurde seitdem in seine Organisation eingegliedert. Die Hauptmerkmale von Riak sind:

- Hohe Verfügbarkeit: Wenn ein Knoten ausfällt, kann er durch einen anderen Knoten im Cluster ersetzt werden

- Skalierbarkeit: Es kann horizontal skaliert werden, um große Datenmengen zu verarbeiten

- Erweiterbarkeit: Es unterstützt Plug-Ins, die neue Funktionen hinzufügen können

Gebiet

Terstore ist eine Big-Data-Datenbank, die auf Apache Cassandra basiert. Es ist eine NoSQL-Datenbank, was bedeutet, dass sie JSON für ihr Datenmodell verwendet. Terstore bietet eine Reihe von Funktionen zum Speichern und Abfragen großer Datensätze, einschließlich Unterstützung für Polygongeometrie, geografische Daten und sogar Textanalyse.

Es ist in Java geschrieben. Das Beste an Terstore ist, dass es einfach einzurichten und sofort einsatzbereit ist. Es sind keine Installationsschritte erforderlich; Laden Sie einfach die Dateien herunter, entpacken Sie sie und verwenden Sie die Datenbank! Im Lieferumfang von Restore sind hilfreiche Tutorials enthalten, die Sie durch die Einrichtung Ihres ersten Projekts führen, sowie Referenzdokumentationen zur optimalen Verwendung von Terstore in Ihren Anwendungen.

Terrstore ist Open Source, wenn Sie also mit dieser Datenbank etwas Neues aufbauen oder erweitern möchten, zögern Sie nicht! Beachten Sie jedoch, dass einige Funktionen möglicherweise noch nicht verfügbar sind (z. B. räumliche Indizierung).

Kassandra

Cassandra ist ein verteiltes Open-Source-Datenbankverwaltungssystem (DBMS). Es ist ein hochgradig skalierbarer, hochleistungsfähiger, fehlertoleranter und hochverfügbarer Key-Value-Datenspeicher. Es wurde entwickelt, um große Datenmengen über mehrere Knoten hinweg zu verarbeiten, ohne die Verfügbarkeit, Konsistenz oder Haltbarkeit zu beeinträchtigen.

Es unterstützt mehrere Datentypen wie Zeichenfolgen, Hashes, Mengen und sortierte Mengen als Basistypen, die mithilfe von Schlüsseln kombiniert werden, um unabhängige Objekte zu erstellen, die eine Tabelle bilden. Cassandra unterstützt auch die Vektorraumpartitionierung für hohe Verfügbarkeit und Skalierbarkeit.

Zu den bemerkenswerten Merkmalen von Cassandra gehören:

- Hohe Verfügbarkeit

- Hochleistung

- Hoher Durchsatz

- Skalierbarkeit

- Konsistenz

Vergleich der besten Big-Data-Datenbanken

AWS DynamoDB

AWS DynamoDB ist die beste Datenbank für Startups. Es ist ein bedarfsgesteuerter, langlebiger und skalierbarer NoSQL-Datenbankdienst, den Sie in vielen Anwendungen verwenden können.

Es ist für Hochleistungs-Lese-/Schreiboperationen mit niedriger Latenz und vorhersagbarem Durchsatz ausgelegt. Es bietet konsistente Leistung und hohe Verfügbarkeit mit automatischer Skalierung und Notfallwiederherstellung direkt nach dem Auspacken.

DynamoDB bietet außerdem einen einzigen partitionierten Index mit geringem Overhead für alle Tabellen im Cluster. Es unterstützt Primär- und Fremdschlüsseleinschränkungen und Volltextsuchfunktionen zum schnellen Abrufen von Daten aus großen Datensätzen.

Der Hauptvorteil der Verwendung von DynamoDB gegenüber anderen Datenbanken besteht in der Möglichkeit, schnell zu skalieren, wenn zusätzliche Rechenressourcen benötigt werden, ohne zusätzliche Kosten bezahlen oder lange warten zu müssen, bis sie wieder verfügbar sind.

Azure Cosmos DB

Azure Cosmos DB ist eine NoSQL-Datenbank, die speziell für die Anforderungen von Big-Data-Anwendungen entwickelt wurde. Es wurde entwickelt, um riesige Datenmengen zu verarbeiten und bietet Flexibilität bei der Verwendung.

Cosmos DB verwendet eine Key-Value-Store-Architektur und ermöglicht es Ihnen, jede Art von Objekt darin zu speichern. Es beschränkt sich nicht nur auf die Speicherung von Daten, die sich auf Ihr Unternehmen beziehen; Sie können es für Protokolldateien oder alles andere verwenden, was gespeichert werden muss.

Cosmos DB basiert auf einer spaltenorientierten Speicher-Engine, die es ermöglicht, große Datenmengen effizient zu speichern, ohne zusätzlichen Speicherplatz auf Ihrer Festplatte oder Ihrem RAM zu benötigen. Dies bedeutet, dass Cosmos DB im direkten Vergleich mit anderen in Azure verfügbaren Optionen weniger Speicherplatz beansprucht als andere Datenbanktypen.

Eine großartige Funktion von Cosmos DB ist die Möglichkeit, auf mehrere Server zu skalieren; Wenn ein Server ausfällt, kann ein anderer seine Funktion übernehmen, ohne die Leistung Ihrer Anwendung oder Datenbank zu beeinträchtigen.

Amazon-Schlüsselräume

Amazon Keyspaces ist eine NoSQL-Datenbank, die Daten einfach in der Cloud speichert und verwaltet. Es ist für große Datenmengen konzipiert, mit mehreren Spalten pro Zeile und ohne Schema, was es ideal zum Speichern großer Mengen unstrukturierter Informationen macht. Die Open-Source-Software ist auf Java-, Python-, C++- und Node.js-Plattformen verfügbar.

Hauptmerkmale:

- Schemaloses Design für einfache Skalierbarkeit

- Speichert bis zu 2 PB Daten pro Instanz

- Unterstützt die Authentifizierung mit AWS-Anmeldeinformationen

Amazon DocumentDB

Amazon DocumentDB ist eine der besten Big-Data-Datenbanken zum Vergleich. Es verfügt über eine Abfrage-Engine, die parallel ausgeführt und Daten schnell analysiert werden kann, wodurch es sich ideal für große Datenmengen eignet. Beeindruckend ist auch die Unterstützung für komplexe Abfragen, die das Auffinden der relevanten Informationen erleichtert.

Die Amazon DocumentDB-Datenbank ist ein Add-on zu Amazon RDS oder Amazon EC2. Es unterstützt bis zu 1 Milliarde Dokumente und 10 Milliarden Datensätze pro Cluster-Knoten. Es wird auch durch ein branchenführendes Service Level Agreement (SLA) unterstützt.

Der Data Studio-Client ist ein visuelles Tool, mit dem Sie Ihre Daten mit Tools wie Dashboards und Grafiken verwalten können. Sie können es für AWS Cloud Search verwenden, um Dokumente zu finden, sie mit maschinellen Lernmodellen zu analysieren und nach Schlüsselwörtern oder Ausdrücken zu suchen. Mit dem Data Pipeline-Dienst können Sie strukturierte Daten aus beliebigen Quellen in ein strukturiertes Format wie JSON oder XML extrahieren, bevor Sie sie zu Analysezwecken an andere Systeme wie Redshift oder Elasticsearch senden.

Amazon Redshift

Amazon Redshift ist ein schnelles, zuverlässiges und kostengünstiges Data Warehouse für die Cloud. Es basiert auf dem Open-Source-Projekt Apache Phoenix und ist in verschiedenen Größen von 32 GB bis 250 TB erhältlich. Es verfügt über eine vollständige SQL-Schnittstelle und unterstützt sowohl relationale als auch nicht relationale Datenbanken.

Amazon Redshift bietet viele Funktionen, die es gut für Data Warehousing geeignet machen:

- Vollständige SQL-Schnittstelle

- Unterstützt sowohl relationale als auch nicht relationale Datenbanken

- Speichert Ihre Daten sicher in einem verschlüsselten Format in der automatisierten Infrastruktur von AWS.

Zusätzlich zu diesen Funktionen Amazon Redshift bietet einige weitere großartige Vorteile:

- Es ist einfach einzurichten und zu bedienen, was bedeutet, dass Sie es sofort verwenden können, ohne umfassende Kenntnisse im IT-Infrastrukturmanagement oder fortgeschrittene Programmierkenntnisse zu benötigen.

- Sie zahlen nur für das, was Sie nutzen – keine Vorabkosten oder langfristigen Verpflichtungen mit diesem Service.

- Amazon Redshift hilft Unternehmen, die wachsenden Anforderungen von Big Data zu bewältigen, unabhängig davon, ob es sich um die Speicherung strukturierter oder unstrukturierter Daten handelt.

Wenn Sie ein Unternehmen sind und riesige Datenmengen sammeln müssen, um Ihre Marketingbemühungen zu unterstützen, sollten Sie die Verwendung einer Open-Source-Big-Data-Datenbank in Betracht ziehen. Diese Tools können alle von Ihnen gesammelten Daten analysieren und Ihnen Zugriff auf nützliche Statistiken geben. Sie werden Ihre Arbeit erheblich erleichtern und Ihnen helfen, genauere Informationen in die Tat umzusetzen.

Über das Big-Data-Datenbankproblem

-

Was ist eine Big-Data-Datenbank und wie unterscheidet sie sich von herkömmlichen Datenbanken?

Eine Big-Data-Datenbank ist eine Datenbank, die darauf ausgelegt ist, große Mengen strukturierter, halbstrukturierter und unstrukturierter Daten zu verarbeiten und zu verwalten. Dies unterscheidet sich von herkömmlichen Datenbanken, die normalerweise nur für die Verarbeitung strukturierter Daten ausgelegt sind.

-

Wie gehen Big-Data-Datenbanken mit der Speicherung und Verarbeitung großer Datenmengen um?

Big-Data-Datenbanken verwenden in der Regel verteilte Rechen- und Speicherarchitekturen wie Hadoop und Apache Spark, um große Datenmengen zu speichern und zu verarbeiten. Diese Architekturen ermöglichen das Speichern und Verarbeiten von Daten über mehrere Knoten in einem Cluster hinweg, wodurch Leistung und Skalierbarkeit verbessert werden.

-

Was sind einige der beliebtesten Big-Data-Datenbanken und was sind ihre Hauptmerkmale?

Einige beliebte Big-Data-Datenbanken sind Apache HBase, MongoDB, Cassandra und Couchbase. Diese Datenbanken sind darauf ausgelegt, große Datenmengen zu verarbeiten, Skalierbarkeit und Leistung zu bieten und Datenverarbeitung und -analyse in Echtzeit zu unterstützen.

-

Wie unterstützen Big-Data-Datenbanken die Datenverarbeitung und -analyse in Echtzeit?

Big-Data-Datenbanken unterstützen die Datenverarbeitung und -analyse in Echtzeit, indem sie Funktionen wie In-Memory-Verarbeitung, verteiltes Computing und Echtzeit-Analyse-Engines bereitstellen. Diese Funktionen ermöglichen die Verarbeitung und Analyse von Daten in Echtzeit, sodass Unternehmen schnellere und fundiertere Entscheidungen treffen können.

-

Welche Vorteile bietet die Verwendung einer Big-Data-Datenbank für Business Intelligence und Analysen?

Zu den Vorteilen der Verwendung einer Big-Data-Datenbank für Business Intelligence und Analysen gehören eine verbesserte Datenverarbeitungs- und Analyseleistung, Skalierbarkeit und die Fähigkeit, große Datenmengen zu verarbeiten. Dadurch können Unternehmen schneller und effektiver Erkenntnisse aus ihren Daten gewinnen, was zu einer besseren Entscheidungsfindung und einem Wettbewerbsvorteil führt.

-

Wie unterstützen Big-Data-Datenbanken maschinelles Lernen und Anwendungen der künstlichen Intelligenz?

Big-Data-Datenbanken unterstützen Anwendungen für maschinelles Lernen und künstliche Intelligenz, indem sie Funktionen wie Echtzeitanalysen, Datenvorverarbeitung und Integration in Frameworks für maschinelles Lernen bereitstellen. Auf diese Weise können Unternehmen Modelle für maschinelles Lernen mit großen Datenmengen erstellen und bereitstellen.

-

Wie gehen Big-Data-Datenbanken mit unstrukturierten Daten wie Text, Bildern und Videos um?

Big-Data-Datenbanken verarbeiten unstrukturierte Daten mithilfe von Dokumentenindizierung, Textanalyse und Bilderkennungstechniken. Diese Techniken ermöglichen die Verarbeitung und Analyse unstrukturierter Daten in einem strukturierten Format, sodass Unternehmen Erkenntnisse aus diesen Daten ableiten können.

-

Wie gehen Big-Data-Datenbanken mit Datenkonsistenz und -zuverlässigkeit um?

Big-Data-Datenbanken sorgen für Datenkonsistenz und -zuverlässigkeit durch Funktionen wie Replikation und Fehlertoleranz. Diese Funktionen stellen sicher, dass Daten auch bei Hardwareausfällen oder anderen Problemen zuverlässig gespeichert und verarbeitet werden.

-

Wie gehen Big-Data-Datenbanken mit Datensicherung und Disaster Recovery um?

Big-Data-Datenbanken handhaben Datensicherungen und Notfallwiederherstellung durch Funktionen wie Datenreplikation, Sicherungs- und Wiederherstellungsverfahren und Notfallwiederherstellungspläne. Diese Funktionen stellen sicher, dass Daten während einer Katastrophe oder eines Verlustes wiederhergestellt werden können.

-

Was sind die Leistungsüberlegungen bei der Arbeit mit Big-Data-Datenbanken?

Bei der Arbeit mit Big-Data-Datenbanken umfassen Leistungsüberlegungen Datenvolumen, Datenzugriffsmuster und Hardwarekonfiguration. Unternehmen müssen möglicherweise Techniken verwenden, um die Leistung zu optimieren, wie z. B. Datenpartitionierung, Indizierung und Caching.

-

Wie gehen Big-Data-Datenbanken mit Data Governance und Compliance um?

Big-Data-Datenbanken handhaben Data Governance und Compliance durch Funktionen wie Zugriffskontrolle, Auditing und Compliance-Berichte. Diese Funktionen stellen sicher, dass Daten in Übereinstimmung mit gesetzlichen und Compliance-Anforderungen verwaltet werden.

-

Was sind die Kostenüberlegungen bei der Bereitstellung und Verwaltung einer Big Data-Datenbank?

Zu den Kostenüberlegungen bei der Bereitstellung und Verwaltung einer Big-Data-Datenbank gehören Hardware, Lizenzierung sowie laufende Wartungs- und Supportkosten. Unternehmen müssen möglicherweise Faktoren berücksichtigen, um die Kosten zu minimieren, wie z. B. Datenkomprimierung, Hardwareoptimierung und Open-Source-Softwareoptionen.