Vision-Sensoren werden in verschiedenen Branchen eingesetzt, darunter Robotik, Automobilbau und Videospiele. Vision-Sensoren werden seit Jahrzehnten entwickelt, und die Technologie hat sich erheblich verbessert. Dieser Artikel gibt einen Überblick über die Grundlagen von Bildverarbeitungssensoren und ihre Funktionsweise. Wir gehen auch auf einige wichtige technische Begriffe ein, die Sie bei der Arbeit mit Bildverarbeitungssensoren kennen müssen. Schließlich werden wir einige Anwendungen für Bildverarbeitungssensoren besprechen, damit Sie sehen können, wie sie heute in realen Anwendungen eingesetzt werden!

Funktionsprinzip des Vision-Sensors

Vision-Sensoren bestehen in der Regel aus einer Kamera, einem Display, einer Schnittstelle und einem Computerprozessor. Es verwendet diese Komponenten in erster Linie, um industrielle Prozesse und Entscheidungen zu automatisieren. Es zeichnet Messungen von Objekten auf und trifft Pass/Fail-Entscheidungen. Er unterstützt auch die Prüfung der analysierbaren Produktqualität. Ein Bildverarbeitungssensor mit einem integrierten Prozessor kann als intelligente Kamera. Eine intelligente Kamera ist nicht nur in der Lage, Bilder zu erfassen, sondern auch zu verarbeiten. Diese Kamera ermöglicht verschiedene Stufen der integrierten Bildverarbeitung und ist ein beliebtes Beispiel für einen Bildverarbeitungssensor für Hobbyfotografen.

Vision-Sensoren verwenden Bilder, um das Vorhandensein, die Ausrichtung und die Genauigkeit eines bestimmten Objekts zu bestimmen. Es unterstützt die Bilderfassung und Bildverarbeitung. Es kann auch a verwenden Einzelsensor für Mehrpunkterkennung. Der Vision-Sensor ist für den Datenaustausch zwischen der Kamera und der computerverarbeiteten Einheit vorgesehen. Es vergleicht und analysiert das erfasste Bild mit einem im Speicher gespeicherten Referenzbild. Angenommen, der Bildsensor ist mit einem Einstellstatus von acht in den Körper eingesetzten Schrauben eingerichtet. Dann kann es die fehlerhaften Teile während des Inspektionsprozesses schnell identifizieren. Diese fehlerhaften Komponenten können Komponenten mit nur sieben Schrauben oder falsch ausgerichteten Schrauben an der Maschine sein. Außerdem kann es korrekte Beurteilungen über die Position und den Rotationswinkel der Maschinenteile vornehmen.

Es gibt einen klaren Unterschied zwischen diesen Sensoren und Bilderkennungssystemen. Sie machen die Installation und den Betrieb des Geräts extrem einfach. Sie unterscheiden sich auch von anderen Allzwecksensoren. Ein typisches Beispiel ist ein einzelner Vision-Sensor, der mehrere Punkte erkennen kann. Er ermöglicht auch die Erkennung von Objekten mit inkonsistenten Zielpositionen.

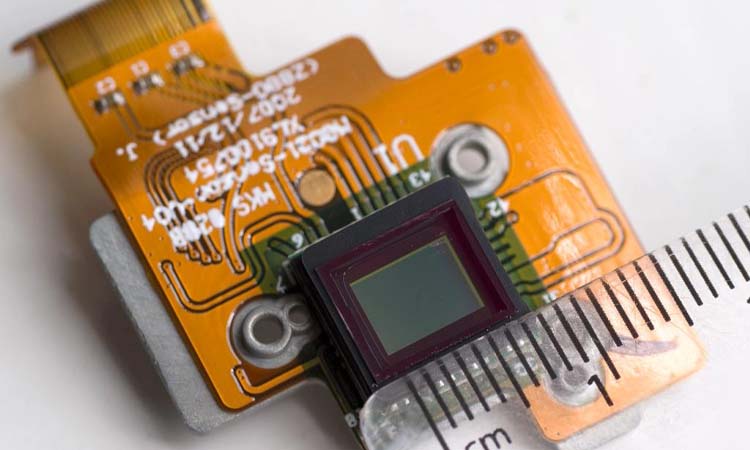

Die Vision-Sensoren sind als Monochrom- und Farbmodelle erhältlich. Das monochromatische Modell identifiziert hauptsächlich den Intensitätsbereich zwischen weißen und schwarzen Bereichen. Die Kamera nimmt das Modellbild auf. Ein optischer Empfänger (CMOS-kompatibel) leitet das aufgenommene Bild durch die Kamera. Dann wandelt er es in ein elektrisches Signal um. Er unterstützt die Erkennung von Form, Ausrichtung und Helligkeit der Objekte. Das vom Farbmodell empfangene Licht wird in Rot, Grün und Blau aufgeteilt. Es ermöglicht Menschen, die Farbe eines Objekts anhand des Intensitätsunterschieds zu erkennen.

Technische Begriffsanalyse von Vision Sensor

- Pixel: Es ist die grundlegende lichtempfindliche Einheit auf dem lichtempfindlichen Gerät. Es ist die kleine Einheit eines Bildes, die die Kamera erkennen kann. Einfach ausgedrückt, ist es eine Kombination aus Bildern und Elementen.

- Graustufen: Die Intensität des Lichts, dem ein Objekt ausgesetzt ist. Sie klassifiziert die Intensität des Lichts, dem ein Objekt ausgesetzt ist, von Schwarz bis Weiß. Sie hat insgesamt 256 Graustufen.

- Arbeitsabstand: Der Abstand vom Objektivtubus zum Objekt

- Sichtfeld (FOV): Der physische Bereich, der mit einer Kamera gesehen werden kann. Das Sichtfeld wird aus den allgemeinen Werten der Lichtquelle und der aktiven Fläche berechnet:

Die longitudinale Länge der effektiven Fläche der Kamera (V) / optisches Vielfaches (M) = Sichtfeld (V)

Transversale Länge der effektiven Fläche der Kamera (H) / optisches Vielfaches (M)= Sichtfeld (H)

Vertikale Länge (V) oder horizontale Länge (M) des effektiven Bereichs der Kamera = Größe eines Pixels der Kamera × Anzahl der effektiven Pixel (V) oder (H) - Schärfentiefe: Der Abstand zwischen der Vorder- und Rückseite eines scharfen Bildes eines Objekts im Fokus.

- Brennweite (f): Der Abstand von der Mitte eines Objektivs zu seinem Brennpunkt

- Objektiv mit fester Fokussierung: Die Brennweite des Objektivs. Das Objektiv mit festem Fokus kann man nicht einstellen. Man kann es nicht regulieren.

- Zoomobjektiv: Einstellbare Objektivbrennweite.

- Kantenluminanz: Prozentsatz der zentralen und peripheren Beleuchtung

- Modulationsübertragungsfunktion (MTF): Die Intensitätsänderung der Objektoberfläche. Diese Funktion stellt die Abbildungsleistung des Objektivs und den Kontrast des abgebildeten Objekts dar.

- Binarisierung: Konvertiert Farben der Konzentration 256. Ordnung in Schwarz und Weiß. Normalerweise folgt auf den Binarisierungsprozess die Messung der weißen Pixel.

- Auslöser: Ein Gerät, das zur Steuerung des Zeitpunkts der Belichtung eines fotografischen Elements verwendet wird.

- Blende: Eine Vorrichtung, die die Lichtmenge steuert, die durch das Objektiv in den Körper gelangt. Sie befindet sich normalerweise im Inneren des Objektivs. Die Blendenzahl wird oft verwendet, um die Größe der Blende anzugeben.

- Bild-Eingabe-Zyklus: Zeit für die Aufnahme eines Bildes.

- Präzision: Die Differenz zwischen dem gemessenen Wert und dem wahren Wert

- Replizieren Sie den Wert: Differenz der Werte aus mehreren Tests

- Auflösung: Die Anzahl der schwarzen und weißen Linien, die in der Mitte von 1 mm sichtbar sind. Die Einheit ist (lp)/mm.

- Belichtungszeit: Der Prozess, durch den Licht auf der Oberfläche eines lichtempfindlichen Geräts wahrgenommen wird

- Industriekameras - Objektiv-Schnittstelle

| Interface Typ | C | CS | 4/3口 | F | EF | PK | C/Y |

| Flansch Rückseite Brennweite | 17.526 | 12.5 | 38.58 | 46.5 | 44 | 45.5 | 45.5 |

| Bajonettring-Durchmesser(mm) | 1(INCH) | 1(INCH) | 46.5 | 47 | 54 | 48.5 | 48 |

Vision Sensoren Typen

Vision- und Bildsensoren lassen sich je nach Aufbau und Komponenten in zwei Kategorien einteilen. Diese beiden Kategorien sind ladungsgekoppelte Bauelemente und komplementäre Metalloxid-Halbleiter (CMOS). Ladungsgekoppelte Bauelemente verwenden ein hoch lichtempfindliches Halbleitermaterial. Es wandelt Licht in elektrische Ladung um und wandelt diese über einen Analog-Digital-Wandler-Chip in ein digitales Signal um.

CMOS verwendet Halbleiter, die aus zwei Elementen bestehen: Silizium und Germanium. Dieses Material ermöglicht die Koexistenz mit N- und P-Halbleitern auf CMOS. Der von beiden erzeugte Strom kann aufgezeichnet und von einem Verarbeitungschip in ein Bild interpretiert werden. Bildsensoren vom Typ CCD arbeiten mit sehr geringem Rauschen. Der Sensor kann auch bei schwachen Umgebungsbedingungen einen guten Zustand beibehalten. Der CMOS-Bildsensor hat eine bessere Qualität als der normale Sensor. Er kann mit einer Niederspannungsstromversorgung betrieben werden.

Vision-System vs. Vision-Sensor

Die Begriffe Vision System und Vision Sensor werden oft synonym verwendet, es gibt jedoch einige feine Unterschiede:

- Ein Vision-Sensor ist eine einzelne Kamera oder ein Bildsensor, der visuelle Informationen erfasst. Es wandelt die optischen Informationen in digitale Bilder um, die verarbeitet werden können. Beispiele sind CMOS-Kameras, CCD-Kameras usw.

- Ein Bildverarbeitungssystem umfasst mehrere Bildverarbeitungssensoren und zusätzliche Komponenten, um visuelle Informationen auf fortschrittlichere Weise wahrzunehmen, zu analysieren und zu interpretieren. Ein Bildverarbeitungssystem umfasst normalerweise:

- Mehrere Kameras mit unterschiedlichen Objektiven, Perspektiven, Sichtfeldern usw. für Stereovision, Panoramaansicht usw.

- Bildverarbeitungshardware/-software für Aufgaben wie Bildverbesserung, Segmentierung, Objekterkennung, 3D-Rekonstruktion, Tracking usw.

- Beleuchtungsausrüstung, um die Szene richtig zu beleuchten.

- Mechanische Komponenten zur Steuerung der Kamerapositionierung und des Fokus.

- Rechenleistung, um die visuellen Daten in Echtzeit zu verarbeiten.

Ein Bildverarbeitungssystem bietet also eine ganzheitlichere Lösung für die maschinelle Wahrnehmung mit Kameras und zugehöriger Hardware/Software. Vision-Sensoren sind Schlüsselkomponenten eines Vision-Systems, aber ein System umfasst auch zusätzliche Elemente.

Vision-Systeme sind nützlich für Anwendungen wie autonome Fahrzeuge, Roboter-Vision, visuelle Inspektion, Überwachung, Gesichtserkennung, Gestenerkennung, Verfolgung und mehr. Single-Vision-Sensoren haben eingeschränktere Fähigkeiten für komplexe Aufgaben der maschinellen Wahrnehmung.

Zusamenfassend, Ein Vision-System zielt darauf ab, Maschinen mit visueller „Sicht“ auszustatten, während ein Vision-Sensor darauf abzielt, visuelle Informationen in Form von digitalen Bildern zu erfassen. Ein gutes Bildverarbeitungssystem stützt sich auf hochwertige Bildverarbeitungssensoren, bietet jedoch viel ausgefeiltere visuelle Funktionen.

Vision Sensor Eigenschaften

Installation

Bei der Verwendung von Kameras in Bildsensoren sind Menschen anfällig für Schäden und Verluste. Die Härtung der Kameratasche und des Objektivs hilft, Schäden an der Kamera zu vermeiden. Die Kameras in diesen Vision-Sensoren werden während des Herstellungsprozesses fest installiert. Die feste Installation stellt sicher, dass die Kamera während des Gebrauchs das richtige Sichtfeld aufzeichnen kann. Die meisten Benutzer verwenden auch Ständer, Armlehnen und Stoßdämpfer, um die Kamera zu platzieren und zu schützen.

Inspektion

Vision-Sensoren können so programmiert werden, dass sie viele verschiedene Merkmale erkennen. Zum Beispiel:

- Flächensensoren können einige fehlende Merkmale, wie z.B. Löcher, in einem zu bearbeitenden Teil erkennen. Sie prüft die Blisterpackung, um sicherzustellen, dass jede Blisterpackung gefüllt ist.

- Der Defektsensor prüft einen Artikeldefekt. Zum Beispiel Kratzer auf der Oberfläche und Fremdkörper auf dem Verpackungsmaterial.

- Passen Sie den Sensor an, um die Position des Etiketts zu überprüfen. Es vergleicht das erzeugte Muster mit dem Referenzmuster. Es prüft die Position des Etiketts auf der Verpackung durch Vergleich.

- Klassifizierung Sensorinspektionsteile. Es verwendet mehrere Modi, um Teile zu inspizieren und auszurichten. Wir können es im Operationssaal verwenden, um zu überprüfen, ob alle Komponenten des Operationssets an ihrem Platz sind.

Vision Sensor Anwendung

Pixelzähler Sensor

Der Pixelzähler-Sensor dient zur Messung eines Objekts anhand einzelner Pixel mit demselben Grauwert im berechneten Bild. Der Sensor hat einen einzigartigen Ansatz zur Bestimmung von Form, Größe und Schattierung einzelner Objekte. Der Sensor bestimmt die Graustufenwerte seiner Objekte, indem er sie gruppiert. Pixelzähler-Sensoren werden in der Regel wie folgt eingesetzt:

- Analyse der Schweißpunkte

- Überprüfung von fehlenden Gewinden in Metallteilen

- Erkennung von Registermarken

- Analyse der Fugenleimmenge

- Kontrasterfassung bei der Montage

- Überprüfung der korrekten Form von spritzgegossenen Produkten

- Berechnung der Anzahl der Löcher im Rotor

Code-Leser

Codeleser sind eine der beliebtesten Anwendungen für Vision-Sensoren. Der Sensor ermöglicht das Lesen von Barcodes und bestimmten zweidimensionalen Codes. Diese spezifischen zweidimensionalen Codes sind zweidimensionale Codes, die der Leser von links nach rechts lesen kann. Der Codeleser kann den Strichcode erkennen und decodieren. Der Reader unterstützt auch das Lesen von Dominosteinen, Sudoku-Rätseln und vielen verschiedenen Schriftstilen. Wir können diese Art von Vision-Sensor auf folgende Weise verwenden:

- Lesen von Produktverpackungsetiketten

- Produkt-Klassifizierung

- Erkennung von Farbmarkierungen

- Erkennung von Defektmarken

Verwandte Lektüre:

- Proximity-Kartenleser: Vor- und Nachteile

- Ein Leitfaden für Einsteiger zu RFID-Kartenlesern und deren Einsatzmöglichkeiten

Profil Sensor

Kontursensoren dienen in erster Linie dazu, zuvor definierte Objekte zu erkennen und zuzuordnen. Der Sensor analysiert die Form und die Kontur von bestimmten Objekten und Objekten in der Verarbeitungspipeline. Er führt auch eine sekundäre Identifizierung der durchlaufenden Objekte durch. Profilsensoren prüfen häufig die Struktur, Ausrichtung, Position und Integrität von Objekten. Anwendungen für Profilsensoren sind:

- Qualitätskontrolle

- Verifizierung von Stanzlöchern in Stahlstäben

- Überprüfung von Radmuttern für Kraftfahrzeuge

- Bestimmung der Position des Löffels in der Verpackung

- Bestimmung von anderen Sensorpositionen

- Überprüfung der korrekten Ausrichtung von Autoteilen

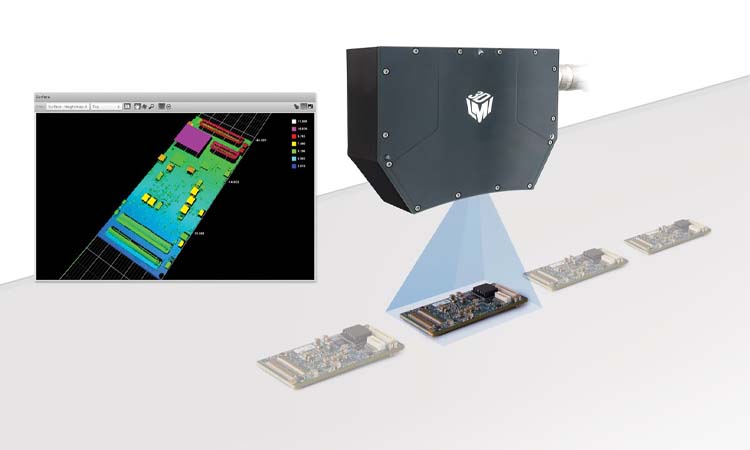

3D Sensor

3D-Sensoren Scannen Sie die Oberfläche und Tiefe eines Objekts. Sie werden in der Regel verwendet, um das Vorhandensein eines Objekts in einem Paket zu analysieren. Sie unterstützen auch die Bestimmung eines Objekts anhand seiner Größe. Gängige Anwendungen für diese Sensoren sind:

- Messung von undurchsichtigen Feststoffen und Schüttgütern in Tanks oder Silos

- Vergewissern Sie sich, dass ein vollständiges Kontingent an Flaschen in der Kiste vorhanden ist.

- Berechnung der Paketgröße und des Volumens im Lager und Distributionszentrum

Wie wähle ich den richtigen Vision Sensor?

Mit der zunehmenden Verbreitung von Bildverarbeitungssensoren wachsen auch unsere Möglichkeiten. Das Auge eines Bildverarbeitungssystems ist eine Kamera. Das Herz der Kamera ist der Bildsensor. Bei den Sensoroptionen müssen wir relativ viel beachten. Dazu gehören seine Genauigkeit, die Kosten des Systems und das Verständnis der Anwendungsanforderungen. Oft können wir die Suche eingrenzen, wenn wir die Hauptmerkmale des Sensors kennen. So können wir die Zeit für die Suche nach dem richtigen Sensor verkürzen.

In einer bestimmten Anwendung können wir die Wahl des Sensors durch drei verschiedene Elemente bestimmen. Diese sind Dynamikumfang, Geschwindigkeit und Reaktionsfähigkeit. Manche Leute sagen, dass der Dynamikbereich die Fähigkeit zur Detailgenauigkeit ist. Dieser Bereich bestimmt die Qualität des Bildes, das das System aufnehmen kann. Die Geschwindigkeit eines Sensors ist die Anzahl der Bilder, die der Sensor pro Sekunde erzeugen kann. Es gibt auch die Ausgabe von Bildern, die das System empfangen kann. Die Empfindlichkeit ist die Effizienz, mit der der Sensor Photonen in Elektronen umwandelt. Die Empfindlichkeit bestimmt den Grad der Helligkeit, den das System benötigt, um ein brauchbares Bild aufzunehmen. Systementwickler können diese Eigenschaften an ihren Benchmarks studieren. Diese Eigenschaften helfen ihnen, die richtigen Entscheidungen zu treffen.

Die meisten Menschen verwenden Vision Sensoren in automatisierte Verarbeitungslinien. Es hilft dem Unternehmen, die Qualität des Produkts innerhalb einer bestimmten Charge zu bestimmen. Er hilft auch dabei, die Einheitlichkeit des Produkts zu gewährleisten. Vision-Sensoren können in einer Vielzahl von Branchen eingesetzt werden. Dazu gehören die Lebensmittel- und Getränkeindustrie, Spritzgussfließbänder, Robotik und die allgemeine Fertigung.

Häufig gestellte Fragen zu Vision-Sensoren

-

Was sind Vision Sensoren und wie funktionieren sie?

Vision-Sensoren verwenden Kameras und Bildverarbeitungsalgorithmen, um visuelle Daten zu erfassen, zu analysieren und zu interpretieren. Sie erfassen Bilder eines physischen Objekts und verwenden Algorithmen, um nützliche Informationen zu extrahieren.

-

Welche Arten von Vision-Sensoren gibt es?

Zu den verschiedenen verfügbaren Arten von Vision-Sensoren gehören 2D- und 3D-, Farb-, Wärme- und Infrarotsensoren.

-

Wie handhaben Vision-Sensoren die Bilderfassung und -verarbeitung?

AVision-Sensoren übernehmen die Bilderfassung und -verarbeitung mithilfe von Kameras, Objektiven und Bildverarbeitungsalgorithmen, die nützliche Informationen aus den erfassten Bildern extrahieren.

-

Welche unterschiedlichen Kommunikationsprotokolle werden in Vision-Sensor-Systemen verwendet?

Zu den verschiedenen Kommunikationsprotokollen, die in Vision Sensor-Systemen verwendet werden, gehören Ethernet-, RS-232-, USB- und drahtlose Protokolle.

-

Wie handhaben Vision-Sensoren das Energiemanagement für den Langzeitbetrieb?

Vision-Sensoren übernehmen das Energiemanagement für den Langzeitbetrieb mit stromsparenden Komponenten, energieeffizienten Designs und Energiesparmodi.

-

Was sind die Unterschiede zwischen 2D- und 3D-Vision-Sensoren?

2D-Vision-Sensoren erfassen zweidimensionale Bilder, während 3D-Vision-Sensoren dreidimensionale Bilder erfassen, was eine genauere Tiefenwahrnehmung ermöglicht.

-

Wie gehen Vision Sensoren mit Änderungen der Licht- und Umgebungsbedingungen um?

Vision-Sensoren verarbeiten Änderungen der Licht- und Umgebungsbedingungen durch adaptive Algorithmen und Beleuchtungskompensationstechniken.

-

Wie können Vision Sensoren für maximale Effizienz in andere automatisierte Systeme integriert werden?

Vision-Sensoren können mithilfe von APIs und Protokollen in andere automatisierte Systeme integriert werden, was Datenaustausch und Interoperabilität ermöglicht.